| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- 딥러닝

- 오픈소스

- PYTHON

- LORA

- OpenAI

- 휴머노이드 로봇

- 오픈AI

- XAI

- 생성형AI

- tts

- ChatGPT

- ai 챗봇

- gaussian splatting

- 우분투

- 시간적 일관성

- AI

- 실시간 렌더링

- OpenCV

- 트랜스포머

- 강화 학습

- 일론 머스크

- 멀티모달

- 오블완

- 확산 모델

- AI 기술

- 티스토리챌린지

- 인공지능

- LLM

- 메타

- 자연어 처리

- Today

- Total

AI 탐구노트

Diffusion Self-Distillation(DSD) : 확산모델 활용한 제로샷 맞춤형 이미지 생성 본문

최근 몇 년간 텍스트-이미지 변환 확산 모델(Text-to-Image Diffusion Models)은 이미지 생성 기술의 새로운 기준을 정립하며 놀라운 성과를 보였습니다. 그러나 이러한 모델들은 사용자가 원하는 세밀한 제어와 편집 기능을 충분히 제공하지 못하는 한계를 가지고 있습니다. 예를 들어, 특정 캐릭터를 다양한 맥락에서 일관되게 유지하면서 생성하는 것은 여전히 해결해야 할 도전 과제입니다.

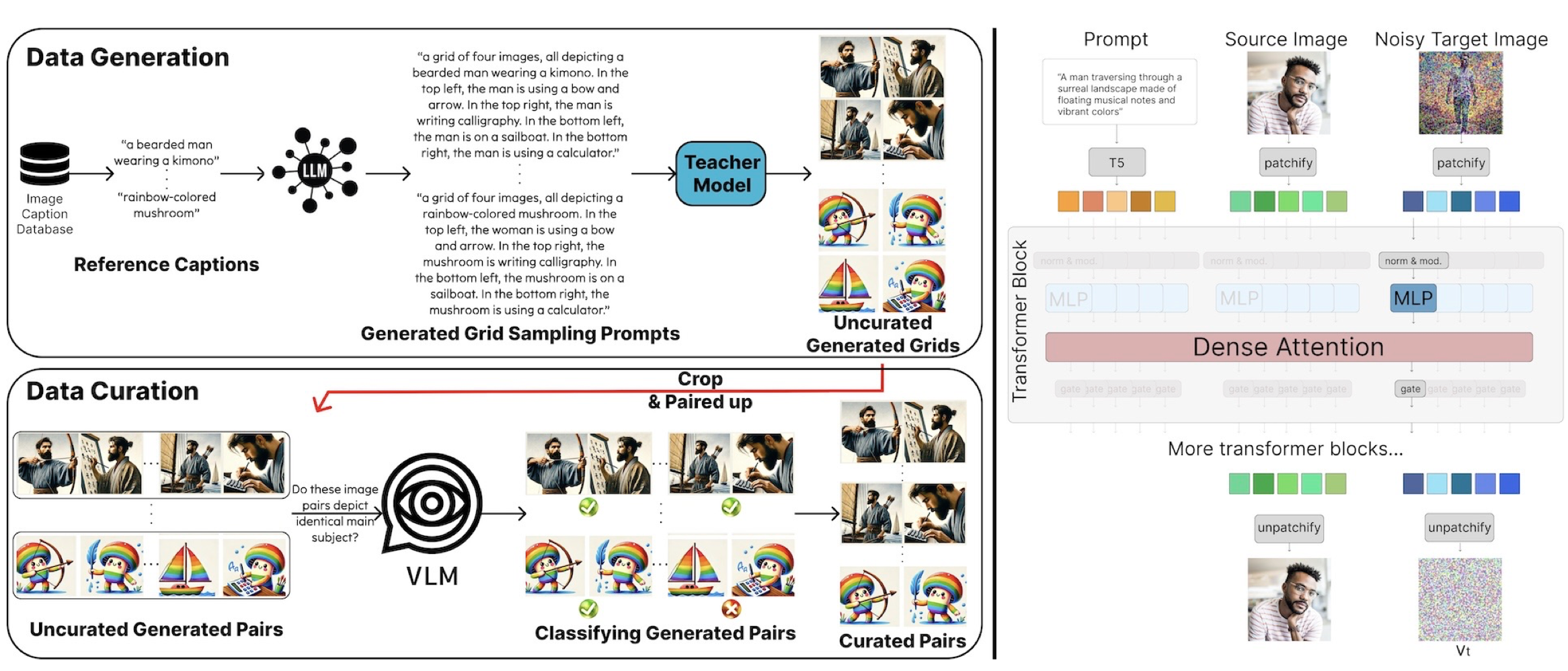

이러한 한계를 극복하기 위해 Diffusion Self-Distillation(DSD) 기법이 제안되었습니다. DSD는 기존의 확산 모델을 활용해 자체적으로 학습 데이터를 생성하고, 이를 기반으로 모델을 미세 조정하여 이미지 편집 및 생성 능력을 강화하는 방법입니다. 본 논문에서는 DSD를 이용해 제로샷(Zero-Shot) 방식으로 맞춤형 이미지 생성을 수행하는 방법을 제안하며, 이를 통해 기존 기법보다 높은 일관성과 유연성을 제공할 수 있음을 입증합니다.

기존 이미지 생성 방식의 문제점

기존의 맞춤형 이미지 생성 방식은 다음과 같은 한계를 가지고 있습니다.

- 세밀한 제어 부족

- 텍스트-이미지 모델은 강력한 이미지 생성 능력을 갖추고 있지만, 특정 개체나 캐릭터의 일관된 재현이 어렵습니다.

- 사용자가 원하는 세부적인 스타일이나 개체의 특정 속성을 반영하기 힘듭니다.

- 고비용의 데이터 학습 필요

- 기존 방법들은 모델을 개별적으로 튜닝해야 하며, 이를 위해 많은 양의 데이터와 연산 자원이 필요합니다.

- DreamBooth와 같은 기존의 모델 튜닝 방식은 학습 속도가 느리고, 새로운 개체나 스타일을 적용할 때마다 추가적인 학습이 필요합니다.

- 제로샷 방법의 한계

- 일부 제로샷 기반 모델(IP-Adapter, InstantID 등)은 빠른 생성이 가능하지만, 세밀한 커스터마이징이 어렵습니다.

- 특히, InstantID는 얼굴 중심의 맞춤 생성에만 최적화되어 있어 일반적인 객체나 캐릭터의 커스터마이징에는 한계가 있습니다.

Diffusion Self-Distillation(DSD)

1) 기술적 접근 방식

본 논문에서는 Diffusion Self-Distillation(DSD) 기법을 통해 기존 방식의 문제점을 해결합니다.

- 자체 데이터 생성(Self-Distillation)

- 사전 학습된 텍스트-이미지 확산 모델을 활용해 다중 이미지 그리드를 생성하고, 이를 기반으로 데이터 세트를 자동 구축합니다.

- Vision-Language Model(VLM)을 이용해 데이터 품질을 자동으로 평가하고, 신뢰도 높은 데이터만을 선별하여 학습에 활용합니다.

- 병렬 처리 아키텍처 도입

- 이미지-텍스트 입력을 동시에 활용하는 구조로 모델을 확장하여 기존보다 높은 일관성을 유지합니다.

- 기존의 ControlNet, IP-Adapter보다 유연한 구조를 제공하여 다양한 이미지 변형이 가능하도록 설계합니다.

- 효율적인 학습 구조

- 별도의 추가 학습 없이 즉각적으로 특정 개체의 속성을 유지하면서 새로운 스타일이나 포즈를 반영할 수 있습니다.

- 모델을 개별 개체에 맞춰 튜닝할 필요 없이, 다양한 입력 이미지와 텍스트 조합을 지원합니다.

2) 적용된 세부 적용 기술

- 텍스트-이미지 확산 모델 기반 데이터 생성

- LAION 데이터셋에서 참조 이미지 캡션을 선택하고, 이를 LLM을 이용해 신원 보존(Identity-Preserving)이 가능하도록 변환합니다.

- 변환된 캡션을 활용하여 사전 학습된 확산 모델을 통해 다중 이미지 그리드를 생성합니다.

- VLM을 활용한 데이터 필터링

- 생성된 이미지 쌍을 VLM을 통해 분석하고, 동일한 개체를 포함하는지 여부를 자동으로 판별합니다.

- 인간의 수작업 없이 자동으로 데이터 품질을 평가하고, 높은 신뢰도를 가진 샘플만 학습에 사용합니다.

- 병렬 처리 기반 확산 모델 아키텍처

- 입력 이미지를 '영상의 첫 프레임'으로 간주하고, 이를 바탕으로 변환된 이미지를 생성하는 방식으로 학습합니다.

- 이를 통해 구조 보존(Structure-Preserving) 및 신원 보존(Identity-Preserving) 변형이 모두 가능합니다.

3) 제약사항

- 일부 개체에 대한 학습 부족 : 현재 모델은 인간 얼굴 및 일반적인 사물에 대한 학습은 잘 되어 있지만, 특정 도메인(예: 의료 이미지, 과학적 데이터)에 대한 적용은 부족할 수 있습니다.

- 창의성 및 원본 변형 한계 : IP-Adapter와 같은 기존 모델은 종종 입력 이미지를 거의 그대로 복사(Paste)하는 경향이 있어 창의적인 변형이 부족합니다. 본 모델은 이를 일부 개선하였으나, 원본과 완전히 다른 스타일로 변경하는 능력은 제한적일 수 있습니다.

- 시스템 요구사항 : 현재 공개된 코드는 24GB 이상의 VRAM이 필요합니다. 양자화 버전은 개발 중이므로 곧 공개될 것이라고 합니다.

- 학습코드는 아직 공개되지 않았습니다.

Diffusion Self-Distillation(DSD)은 제로샷 방식으로 맞춤형 이미지 생성을 가능하게 하는 혁신적인 접근법입니다. 기존 방식과 비교할 때, 더 적은 연산량과 데이터로도 높은 일관성을 유지할 수 있으며, 사용자 개입 없이 자동으로 데이터 구축이 가능합니다.

본 연구는 AI 기반 콘텐츠 제작의 새로운 가능성을 열며, 예술, 디자인, 게임, 영화 산업 등에서 창작자들에게 유용한 도구가 될 것입니다.

참고자료

- 프로젝트 사이트 (링크)

- 논문) Diffusion Self-Distillation for Zero-Shot Customized Image Generation (링크)

- 코드) 깃헙 (링크)

- 데모) HuggingFace (링크)

Q&A

Q. Diffusion Self-Distillation은 기존 DreamBooth와 어떻게 다른가요?

DreamBooth는 특정 개체를 학습하기 위해 추가적인 학습 단계를 필요로 하지만, DSD는 별도의 추가 학습 없이 기존 모델을 활용해 즉각적인 커스터마이징이 가능합니다.

Q. 이 모델은 모든 유형의 이미지에 적용할 수 있나요?

기본적으로 일반적인 이미지 생성에는 강력한 성능을 보이지만, 의료 및 특수 도메인의 경우 추가적인 학습이 필요할 수 있습니다.

Q. Diffusion Self-Distillation을 활용하면 어떤 응용이 가능할까요?

캐릭터 디자인, 게임 아트 생성, 디지털 일러스트, 영화 및 애니메이션 제작, 광고 및 마케팅 콘텐츠 생성 등에 활용할 수 있습니다.

'AI 기술' 카테고리의 다른 글

| MIDI: 단일 이미지에서 3D 장면 생성을 위한 다중 인스턴스 확산 모델 (1) | 2025.03.15 |

|---|---|

| Audio Flamingo 2: 언어/비언어 소리를 함께 이해하는 오디오-언어 모델 (0) | 2025.03.13 |

| QwQ-32B : 강화 학습을 통한 대규모 언어 모델의 지능 향상 (0) | 2025.03.11 |

| 업무자동화를 위한 오픈소스 No Code 도구 : n8n vs Langflow (0) | 2025.03.10 |

| GLM(Grounded Language Model) : 정확성 높은 RAG 2.0 기반 언어모델 (1) | 2025.03.09 |