| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | |||||

| 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| 10 | 11 | 12 | 13 | 14 | 15 | 16 |

| 17 | 18 | 19 | 20 | 21 | 22 | 23 |

| 24 | 25 | 26 | 27 | 28 | 29 | 30 |

| 31 |

- 감정 표현

- AI 기술

- 확산 모델

- 트랜스포머

- 메타

- AI

- 멀티모달

- 일론 머스크

- ChatGPT

- 다국어 지원

- 강화 학습

- 우분투

- 생성형AI

- 티스토리챌린지

- 휴머노이드 로봇

- 이미지 생성

- 실시간 렌더링

- 자연어 처리

- PYTHON

- 인공지능

- OpenAI

- 딥러닝

- LLM

- 오블완

- Stable Diffusion

- tts

- 오픈AI

- 오픈소스

- 강화학습

- XAI

- Today

- Total

AI 탐구노트

MIDI: 단일 이미지에서 3D 장면 생성을 위한 다중 인스턴스 확산 모델 본문

3D 장면 생성 기술은 가상 현실(VR), 게임, 건축 및 로봇 공학 등 다양한 분야에서 중요한 역할을 합니다. 특히, 단일 이미지에서 3D 장면을 추론하는 기술은 한정된 입력 정보로부터 공간적 관계를 재구성해야 하는 어려움이 있습니다. 기존의 방법들은 대체로 3D 모델을 데이터베이스에서 검색하는 방식이나, 개별 객체를 하나씩 생성하여 조합하는 방식으로 발전해왔습니다.

하지만 이러한 기존 방식들은 다음과 같은 문제를 갖고 있습니다.

- 재구성 방식 : 신경망을 이용하여 3D 장면을 직접 복원하지만, 학습 데이터가 부족하면 일반화 성능이 떨어짐

- 검색 기반 방식 : 기존 3D 모델을 검색하여 결합하지만, 적절한 모델을 찾기가 어렵고 정확한 정렬이 어려움

- 다단계 객체 생성 방식 : 객체별로 개별적인 생성 과정을 거쳐야 하므로 연산량이 크고 오류가 누적될 가능성이 높음

이를 해결하기 위해 본 개발된 것이 MIDI(Multi-Instance Diffusion for Single Image to 3D Scene Generation)입니다. MIDI는 기존의 단일 객체 3D 생성 모델을 확장하여, 다중 인스턴스 확산(Multi-Instance Diffusion) 모델을 사용함으로써 단일 이미지에서 여러 개의 3D 객체를 동시에 생성하고, 이들 간의 상호작용을 직접 학습합니다.

MIDI(Multi-Instance Diffusion for Single Image to 3D Scene Generation)

1) 개요

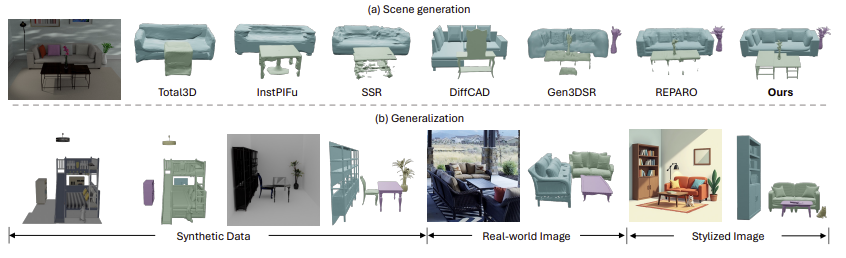

연구 결과, MIDI는 합성 데이터, 실세계 장면 데이터, 텍스트-이미지 확산 모델로 생성된 스타일화된 이미지에서 최첨단 성능을 보였습니다.

2) MIDI의 특징

MIDI는 전체 장면 이미지와 개별 객체 이미지를 함께 사용하여 3D 장면을 만듭니다. 이를 통해 객체들의 위치와 모양이 더 정확하게 배치되며, 복잡한 여러 단계의 작업 없이 효율적으로 생성할 수 있습니다. 특히, MIDI의 다중 인스턴스 주의 메커니즘은 각 객체가 다른 객체들의 정보를 참고할 수 있도록 도와주어, 전체 장면이 자연스럽고 일관되게 구성됩니다.

MIDI의 주요 특징을 다시 정리하면 다음과 같습니다.

- 사전 학습된 3D 객체 생성 모델 활용 : 단일 객체 3D 생성 모델을 다중 객체 생성으로 확장하여, 공간적 일관성을 유지하면서 효율적으로 3D 장면을 생성

- 다중 인스턴스 주의 메커니즘(Multi-Instance Attention Mechanism) : 여러 개의 객체가 동시에 생성되며, 객체 간의 상호작용을 학습하여 위치 및 배치를 최적화

- 전역 장면 정보를 활용한 컨디셔닝(Global Scene Context Conditioning) : 개별 객체뿐만 아니라 전체 장면의 맥락 정보를 반영하여 생성 품질을 향상

3) 세부 적용 기술

MIDI는 크게 3가지 핵심 기술을 사용하여 3D 장면 생성을 수행합니다.

다중 인스턴스 확산 모델(Multi-Instance Diffusion Model)

- 기존 3D 객체 생성 모델을 확장하여, 여러 개의 객체를 동시에 생성할 수 있도록 조정

- 여러 객체의 3D 표현을 병렬로 처리하여 효율적인 연산 수행

- 기존의 Denoising Transformer(DiT) 기반의 확산 모델을 다중 객체 생성을 위한 구조로 개편

다중 인스턴스 주의 메커니즘(Multi-Instance Attention Mechanism)

- 객체 간의 공간적 관계를 효과적으로 모델링

- 기존 자기 주의(Self-Attention) 기법을 확장하여, 서로 다른 객체들 사이의 상호작용을 반영

- 예를 들어, 책상 위에 놓인 물건과 같은 상대적 위치 관계를 자동으로 학습하여 조정

전역 장면 컨디셔닝(Global Scene Context Conditioning)

- 단순히 개별 객체를 생성하는 것이 아니라, 전체 장면의 맥락을 반영

- Vision Transformer(ViT) 기반의 이미지 인코더를 활용하여 장면의 전체적인 분위기와 공간적 정보까지 고려하여 3D 장면을 생성

4) 제약사항

- 작은 객체의 경우 상대적으로 해상도가 낮게 표현될 가능성이 있음

- 현재 데이터셋이 단순한 객체 배치만을 다루고 있어, 복잡한 상호작용(예: 사람이 물건을 들고 있는 상황)까지 모델링하기 어려우며 이를 위해서는 특화된 데이터셋을 이용한 학습이 필요함

MIDI는 단일 이미지에서 3D 장면을 생성하는 데 있어 중요한 진전을 이루었으며, 이미 실시간 응용 가능성과 다양한 데이터셋에서의 강력한 일반화 능력을 보여주고 있습니다. 향후 더 복잡한 객체 상호작용을 모델링하는 방법, 다양한 환경에서의 일반화 성능 등을 개선한다면 3D 콘텐츠 생성 분야에서 다양한 용도로 할용될 수 있을 것입니다.

참고자료

- 사이트) MIDI 프로젝트 사이트 (링크)

- 논문) MIDI: Multi-Instance Diffusion for Single Image to 3D Scene Generation (링크)

- 코드) MIDI 깃헙 (링크)

Q&A

Q. 기존 3D 장면 생성 모델과 MIDI의 차이점은 무엇인가요?

기존 모델은 개별 객체를 하나씩 생성하거나 3D 데이터베이스에서 검색하여 조합하는 방식이었지만, MIDI는 여러 개의 객체를 동시에 생성하고 객체 간의 공간적 관계를 학습하는 점에서 차별화됩니다.

Q. MIDI는 어떤 데이터셋을 사용하여 학습되었나요?

MIDI는 3D-Front 데이터셋을 기반으로 학습되었으며, 추가적으로 Objaverse 단일 객체 데이터셋을 활용하여 일반화 성능을 향상시켰습니다.

Q. MIDI의 한계점은 무엇인가요?

작은 객체는 상대적으로 해상도가 낮게 표현될 가능성이 있으며, 복잡한 객체 간 상호작용(예: 사람이 특정 동작을 수행하는 장면)은 현재 학습 데이터로 충분히 모델링되지 못하는 점이 있습니다.

'AI 기술' 카테고리의 다른 글

| Inductive Moment Matching: 빠르고 안정적인 생성 모델 학습 기법 (0) | 2025.03.18 |

|---|---|

| CPR : 고속 이상 탐지를 위한 계층적 패치 검색 기법 (0) | 2025.03.16 |

| Audio Flamingo 2: 언어/비언어 소리를 함께 이해하는 오디오-언어 모델 (0) | 2025.03.13 |

| Diffusion Self-Distillation(DSD) : 확산모델 활용한 제로샷 맞춤형 이미지 생성 (0) | 2025.03.11 |

| QwQ-32B : 강화 학습을 통한 대규모 언어 모델의 지능 향상 (0) | 2025.03.11 |